Las métricas de las ciencias de cabeza y al revés

Gabriel Vélez Cuartas

Hay definitivamente un conflicto entre los sistemas de citación e indexación y las ciencias sociales y humanas. Ya es conocida la crítica a los modelos cienciométricos tradicionales que desconsideran los aportes de ésta área: problemas de cobertura (Torres y Delgado, 2013; Harzing, 2013; Miguel, 2011), carencia de instrumentos para medir lo existente (Romero, Acosta, Tejada, 2013; DORA, 2012), acceso a información nacional (Marques, 2015), inadecuación de herramientas bibliométricas a las humanidades (Beigel, 2018; Gómez Morales, 2015; Žic Fuchs, 2014), la necesidad de ampliar los criterios de evaluación de la ciencia (Wouters & Hicks, 2015) o las dificultades de los índices sintéticos para la evaluación (Sanz Casado et al, 2013).

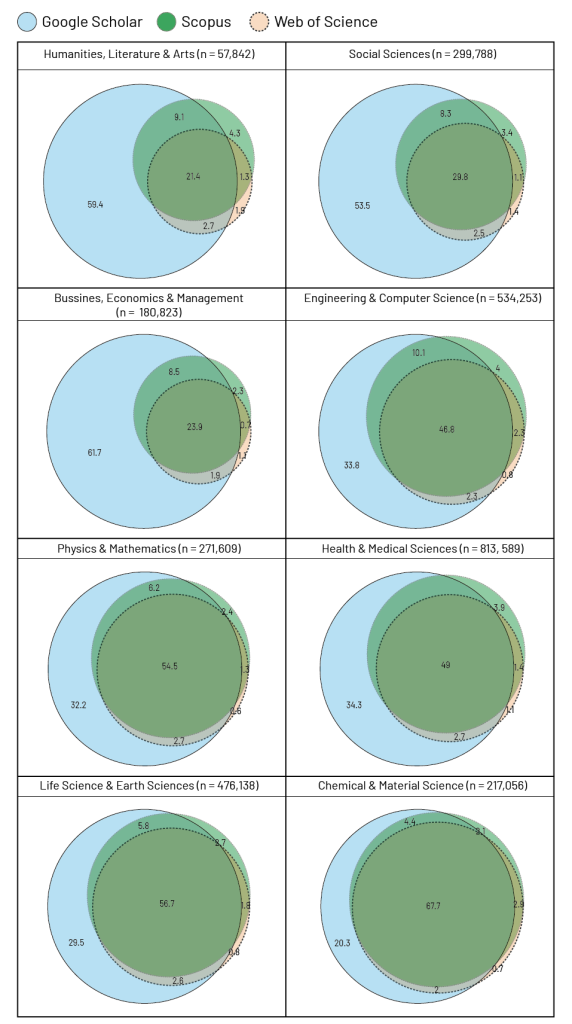

Un ejemplo importante de los límites de la valoración que hacen los instrumentos más utilizados para la evaluación de la producción científica (Factor de Impacto y SJR) lo presenta un estudio que compara el número de citas a artículos en WoS, Scopus y Google Scholar (Martín-Martín et al, 2018). En este estudio se evidencia que en áreas como ciencias sociales, humanidades y artes y economía y negocios, más del 50% de las citas no son considerados por los resultados presentados por WoS y Scopus (ver figura 1). Pareciera Google Scholar un modelo más cercano a las ciencias sociales y humanidades.

Figura 1.

Porcentaje de citas únicas y traslapadas en Google Scholar, Scopus y Web of Science por área temática de documentos citados.

Fuente: Martín-Martín, A., Orduna-Malea, E., Thelwall, M., & Delgado-López-Cózar, E. 2018.

Sin embargo, todavía cabe decir que las métricas se han convertido en un ruido molesto para el desarrollo de las diferentes áreas de conocimiento en las ciencias sociales y las humanidades. Las métricas se observan con desconfianza, la credibilidad sobre los efectos en el fortalecimiento de comunidades académicas es limitada para l@s investigador@s del área. Se hace un gran esfuerzo por publicar en revistas WoS y Scopus con retribuciones escasas, con desconocimiento del impacto real sobre el trabajo de otros colegas, muchos estados del arte incluyen publicaciones que pueden o no ser altamente citadas, los resultados esperados en términos de financiación para los propios proyectos son pobres, la desorientación sobre las formas de posicionamiento en el campo y las verdaderas innovaciones en enfoques es generalizada.

Del lado de las publicaciones, Latinoamérica está excluida de los índices internacionales y por tanto, fuera del foco de sus instituciones. La región ha desarrollado su potencial de comunicación a partir de las revistas universitarias que logran su visibilidad a partir de las redes de facultades y departamentos en la mayoría de los casos pero no al apoyo de las sociedades científicas que permitan convertirlas en escenarios de discusión nacional e internacional. El apoyo gubernamental al desarrollo de estos esfuerzos se ha limitado a su evaluación con criterios propuestos por casas editoriales internacionales o consorcios privados como Elsevier, Clarivate o Google (en el mejor de los casos, que son pocos). Si se considera que parte importante, más del 80% de las revistas presentes en estas bases de datos, son de grandes industrias editoriales (Vélez, Lucio, Leydesdorff, 2016) el debate queda determinado por la dicotomía entre publicar especialmente en revistas europeas y norteamericanas o fortalecer una industria nacional. De un lado se gana en estandarización internacional del otro lado en autodeterminación. Para las ciencias sociales y humanas, esto representa un aspecto importante considerando la importancia de los desarrollos regionales, la importancia del desarrollo de una comunidad interna para Latinoamérica, y los patrones de crecimiento diferenciales de su producción (Engels et al, 2012; Bornmann et al, 2010), pero también el impacto logrado en otra revistas no presentes en Scopus y WoS como demuestran Martín-Martín et al (2018). En otras palabras, la medicina necesita espacios de comunicación globales por la generalización posible de sus resultados, las ciencias sociales y humanas necesitan discutir asuntos regionales como las políticas públicas, la historia regional o la organización del patrimonio de acuerdo a criterios propios, sin olvidar el diálogo internacional.

Con este panorama, las métricas para las ciencias sociales y las humanidades requieren de una urgente reformulación creativa. De un lado deben responder a la orientación de l@s investigador@s en su campo, de otro lado deben hacer visibles las publicaciones que no lo son. Los retos deben ser diferentes a la reformulación de las ecuaciones sobre los mismos datos, de las mismas bases. Tal vez se trate de nuevos índices, pero más importantes son las preguntas que guían a la medición, la concordancia con resultados esperados de quienes son medidos. Sobre todo volver a lo básico de nuestras comunidades, volver a las preguntas fundamentales: para qué escriben l@s investigador@s, para quién, cómo quieren fortalecer sus comunidades, cuáles son los caminos para la comunicación del conocimiento. Una vez establecida una línea base, tal vez se encuentren salidas creativas que permitan orientar la labor.

Del lado de las publicaciones, Latinoamérica está excluida de los índices internacionales y por tanto, fuera del foco de sus instituciones. La región ha desarrollado su potencial de comunicación a partir de las revistas universitarias que logran su visibilidad a partir de las redes de facultades y departamentos en la mayoría de los casos pero no al apoyo de las sociedades científicas que permitan convertirlas en escenarios de discusión nacional e internacional.

Pensar las ciencias como el resultado de la institucionalización de su comunicación deriva en procesos crecientes de experticia temática, diseminación del conocimiento en múltiples fuentes, establecimiento de diálogos con diferentes actores académicos y no académicos y la consolidación de comunidades. De alguna u otra forma hay una competencia abierta en la oferta de soluciones a problemas, pero no necesariamente en competencia contra un solo centro. Se generan heterarquías, redes con múltiples centros y periferias y no sólo una distribución de la producción en cuartiles exactos de impacto, medida contraria a las múltiples redes de libre escala que se pueden encontrar en diferentes áreas de conocimiento. Otras mediciones se pueden hacer:

-

- Observación del conjunto de la producción en la mayor cantidad de bases de datos posibles globales y regionales: Redalyc, Scopus, Scielo, WoS…

- Construcción de mapas de conocimiento que orienten la generación de nuevas investigaciones en donde fácilmente puedan ser ubicadas instituciones e investigador@s expertos.

- Ampliación de la base de observación de la referenciación y citación a otras formas de producción como libros, medios de comunicación, redes sociales para descubrir la utilización de la investigación en diferentes formas de producción y orientada a diferentes públicos.

- Identificación del uso de las fuentes de acceso abierto en contraste con las publicaciones cerradas o con cobro de APC.

- Observar el crecimiento de comunidades temáticas y programas de investigación institucionales e interinstitucionales.

- Descubrir las colaboraciones con sectores no académicos en la construcción de conocimiento y la participación de distintos sectores en el desarrollo de la investigación.

En fin, métricas que respondan a preguntas por el desempeño de l@s investigador@s y no si se está más cerca o lejos de las formas de producción de la física de partículas o la inmunovirología o al impacto de Nature o Science. En este contexto vale la pena regresar a las preguntas. Es propicio para AmeliCA, en su nacimiento y sobre todo para empezar un diálogo real con la comunidad, saber a todas estas, a l@s investigador@s, qué quisieran que apareciera en las mediciones de su propia producción, qué tipo de metas y objetivos tienen que puedan ser monitoreados por alguna métrica. Queda la pregunta abierta.

REFERENCIAS

Beigel, F. (2018). Las relaciones de poder en la ciencia mundial: Un anti-ranking para conocer la ciencia producida en la periferia. Revista Nueva Sociedad 274, 13-28.

Gomez-Morales, Y, J. (2015). Usos y abusos de la bibliometría. Revista Colombiana de Antropología, 51(1), 291-307.

Harzing, A, W. (2013). Document categories in the ISI Web of Knowledge: Misunderstanding the Social Sciences?. Scientometrics, 94, 23–34. DOI 10.1007/s11192-012-0738-1

Marques, F. (2015). Registros Valiosos. Pesquisa FAPESP, 233, 34-37.

Martín-Martín, A., Orduna-Malea, E., Thelwall, M., & Delgado-López-Cózar, E. (2018). Google Scholar, Web of Science, and Scopus: a systematic comparison of citations in 252 subject categories. arXiv:1808.05053v1. DOI: 10.31235/osf.io/42nkm

Miguel, S. (2011). Revistas y producción científica de América Latina y el Caribe: su visibilidad en SciELO, RedALyC y SCOPUS. Revista Interamericana de Bibliotecología, 34(2), 187-199.

Romero-Torres, M., Acosta-Moreno, L.A., & Tejada-Gómez, M.A. (2013). Ranking de revistas científicas en Latinoamérica mediante el índice h: estudio de caso Colombia. Revista Española de Documentación Científica, 36(1). doi: http://dx.doi.org/10.3989/redc.2013.1.876

San Francisco Declaration on Research Assessment- DORA (2013). Recuperado de http://www.ascb.org/SFdeclaration.html

Sanz-Casado, E., García-Zorita, C., Serrano-López, A. E., Efraín-García, P., & De Filipo, D. (2013). Rankings nacionales elaborados a partir de múltiples indicadores frente a los de índices sintéticos. Revista Española de Documentación Científica, 36(3). doi: http://dx.doi.org/10.3989/redc.2013.3.1.023

Torres-Salinas, D. & Delgado-López-Cózar, E. (2013). “Cobertura de las editoriales científicas del Book citation index en ciencias sociales y humanidades: ¿la historia se repite?”. Anuario ThinkEPI, 7, 110-113.

Vélez-Cuartas, G., Lucio-Arias, D., & Leydesdorff, L. (2016). “Regional and global science: Publications from Latin America and the Caribbean in the SciELO Citation Index and the Web of Science”. El profesional de la información, 25(1), 35-46.

Wouter, P. & Hicks, D. (2015). The Leiden Manifesto for research metrics. Nature 520, Abril, 429-531.

Žic Fuchs, M. (2014). Bibliometrics use and abuse in the humanities. Portland press LTD. Recuperado de http://www.portlandpress.com/pp/books/online/wg87/087/0107/0870107.pdf